基于DeepSeek的本地化知识库 RAGFlow 搭建

部署ollama

准备镜像

1 | docker pull ollama/ollama:0.12.6 |

启动镜像

1 | docker run -d --gpus=all -v /opt/ollama/data:/root/.ollama -p 11434:11434 --name ollama ollama/ollama:0.12.6 |

这里我选择直接docker run ,也可以加到ragflow的docker-compse.yml配置中

启动完成后部署**bge-m3**模型

1 | docker exec -it ollama ollama pull bge-m3 |

bge-m3模型一共1.2GB

deepseek-r1:1.5b模型一共1.1GB

部署ragflow

准备配置文件

1 | git clone https://github.com/infiniflow/ragflow.git |

将仓库的docker文件复制到服务器中

需要注意一下.env中使用的ragflow镜像是v0.21.0-slim版,如下:

1 | RAGFLOW_IMAGE=infiniflow/ragflow:v0.21.0-slim |

slim版镜像大约7G左右,如果需要使用全量版,将镜像地址改为v0.21.0

1 | RAGFLOW_IMAGE=infiniflow/ragflow:v0.21.0 |

两个版本的区别在于,v0.21.0包含了一些内置的嵌入模型如 BGE 和 BCE,因为内嵌了模型v0.21.0版本的大小会大很多,大约在30G左右

使用到的镜像列表是:

1 | REPOSITORY TAG IMAGE ID CREATED SIZE |

执行命令启动容器

1 | docker compose up -d |

启动完成后看见如下日志证明启动成功

1 | * Running on all addresses (0.0.0.0) |

浏览器访问

1 | http://192.168.88.135/ |

注:第一次访问需要自己注册账号

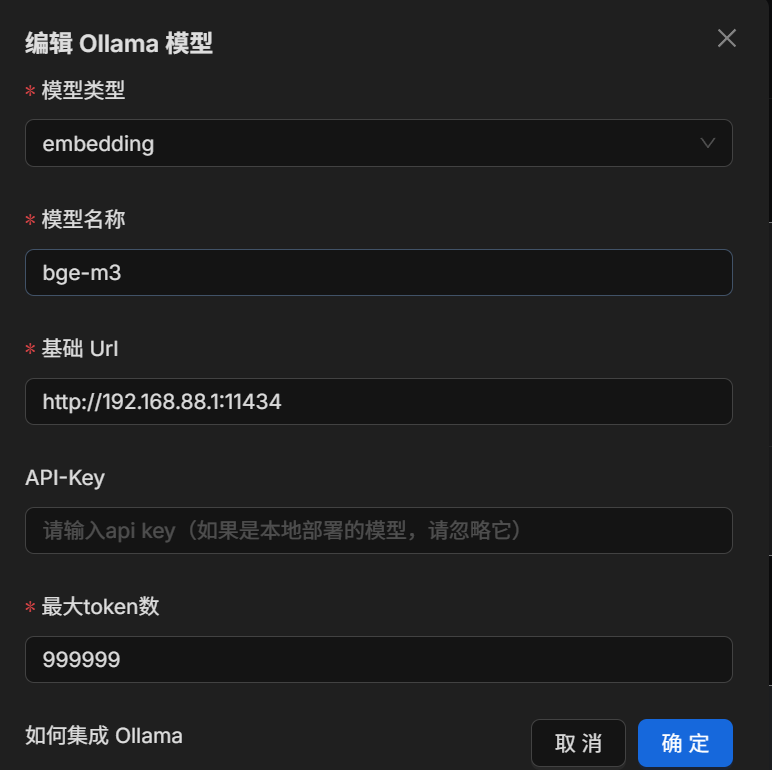

添加模型

登录系统后,访问模型提供商管理页面,

首先添加chat类型模型

然后再添加embedding类型模型

添加完成后需要将这两个模型设置为默认模型

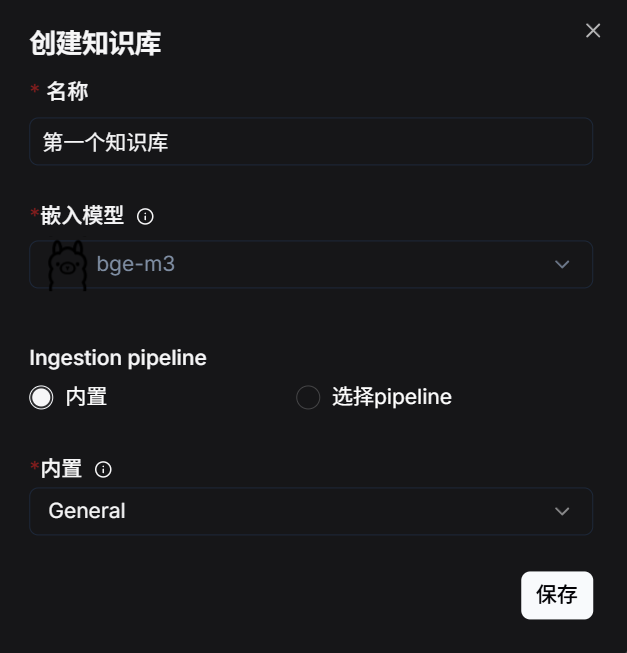

创建知识库

知识库创建完成后新增文件,然后点击开始按钮开始解析文件

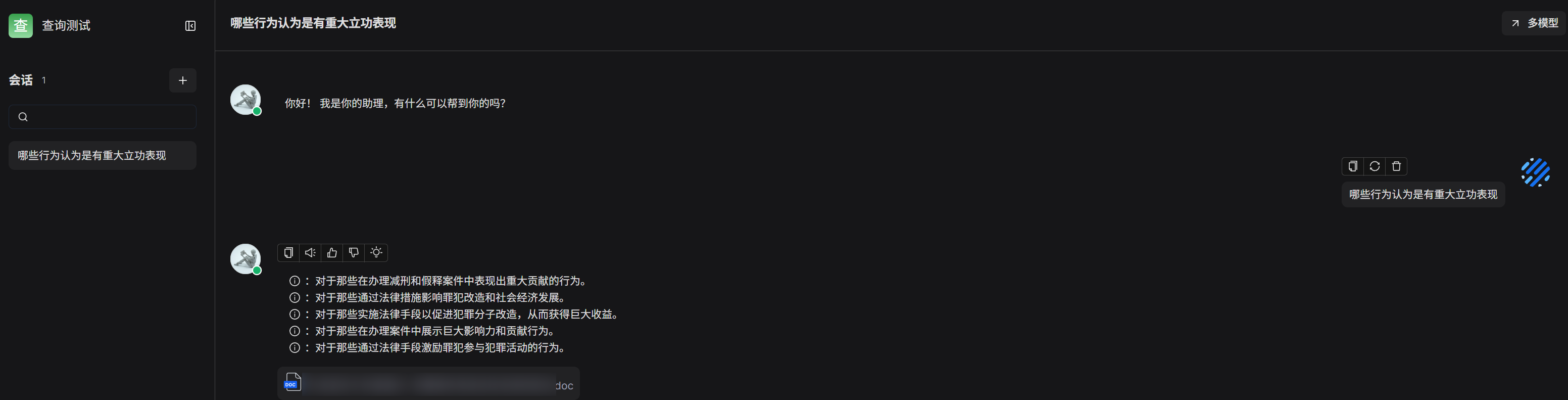

创建对话

在聊天页新建一个聊天

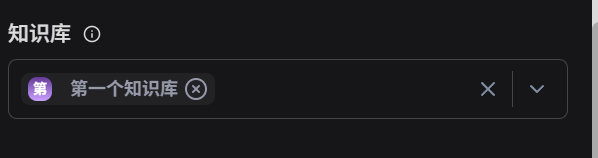

然后在聊天设置中设置一下知识库

最后点击新建会话即可开始对话

本文是原创文章,采用CC BY-NC-SA 4.0协议,完整转载请注明来自Jarome'Blog